모든 규모에 맞는 성능과 효율성

딥 러닝과 생성형 AI가 제공할 수 있는 이점에 대한 수요가 급증하면서 컴퓨팅 성능, 효율성, 유용성, 선택권을 개선해야 할 필요성이 그 어느 때보다 커졌습니다.

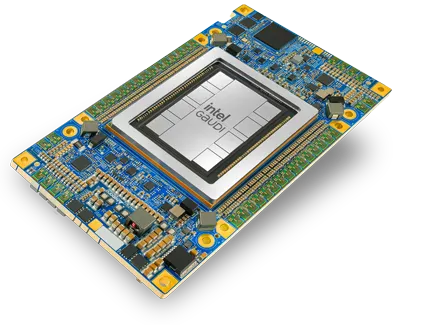

인텔® Gaudi® AI 가속기 및 소프트웨어는 클라우드나 온프레미스의 데이터 센터 훈련 및 추론에 새로운 차원의 컴퓨팅 이점과 선택권을 제공하도록 설계되었습니다.

인텔의 목표는 더 많은 기업과 조직이 AI 딥 러닝의 이점을 더 쉽게 이용할 수 있도록 하여 많은 사람에게 딥 러닝 이점의 제공을 방해하는 장벽을 제거하는 것입니다.

브로슈어 다운로드

인텔 Gaudi 3 가속기로 시간과 전력을 절약하십시오

2x

AI 컴퓨팅(FP8)과 인텔 Gaudi 2 AI 가속기 비교

4x

AI 컴퓨팅(BF16)과 인텔 Gaudi 2 AI 가속기 비교

2x

네트워크 대역폭과 인텔 Gaudi 2 AI 가속기 비교

개방형

NVLink, NVSwitch, InfiniBand와 같은 잠긴 독점 기술에 대한 위험한 투자를 피하십시오.이더넷용으로 제작

이미 보유하고 있는 네트워킹 인프라를 사용하고 표준 이더넷 하드웨어로 미래의 요구 사항을 지원하십시오.더 많은 I/O

H100보다 33% 더 많은 가속기당 I/O 연결을 활용하면 최적화된 비용 효율성으로 대규모 스케일 업과 스케일 아웃을 구현할 수 있습니다.손쉬운 확장

인텔 Gaudi 3 AI 가속기는 가장 크고 복잡한 배포에도 간단하고 비용 효율적인 AI 확장성을 제공하도록 설계되었습니다.딥 러닝 학습 및 추론을 위한 구축 및 설계

인텔® 가우디® AI 가속 플랫폼은 대규모 AI 시대의 학습 및 추론 요구 사항을 해결하기 위해

고안 및 설계되어 기업과 조직에 고성능, 고효율의 딥 러닝 컴퓨팅을 제공합니다.

고안 및 설계되어 기업과 조직에 고성능, 고효율의 딥 러닝 컴퓨팅을 제공합니다.

업계를 선도하는 성능에 도전

딥 러닝 컴퓨팅 성능

MLPerf 결과에 따르면, 인텔® 가우디® 2 AI 가속기는 GPT-3*와 같은 대규모 언어 모델 트레이닝에 있어 Nvidia의 H100을 대체할 수 있는 유일한 대안입니다.

*MLPerf GPT-3 벤치마크, 2023년 12월

가격 대비 성능 효율성

효율적인 설계로

비용 절감

인텔® 가우디® AI 아키텍처는 Amazon EC2 인스턴스에서 최대 40% 더 나은 가격 대비 성능을 입증했습니다.

대규모 확장성

선형에 가까운 확장성

모든 인텔® 가우디® AI 가속기에 24개의 100GbE 포트가 통합되어 있어 방대한 시스템 확장이 가능하고 유연하며 비용 효율적입니다.

사용하기 쉬운 개발 플랫폼

손쉬운 지원을 통해

모델 마이그레이션

성능과 사용 편의성에 최적화된 인텔® 가우디® 소프트웨어는 모델 구축 및 마이그레이션의 기준을 낮춰줍니다.

인텔® 가우디® AI 가속기

대규모 AI 시대를 위해 설계되었습니다.

인텔® 가우디® AI 가속기 사용 사례 및 인텔® 가우디® 소프트웨어 살펴보기

딥 러닝 모델 개발에 최적화되어 있으며 기존 GPU 기반 모델을

인텔® 가우디® AI 가속기 플랫폼 하드웨어로 쉽게 마이그레이션할 수 있습니다.

사용 사례 살펴보기 인텔® 가우디® AI 가속기 플랫폼 하드웨어로 쉽게 마이그레이션할 수 있습니다.

사업 분야별 AI 활용 사례

AI/딥러닝은 거의 모든 경험에서 거의 모든 사람에게 유용한 것으로 나타났으며,

그 가치 제공 범위가 점점 더 넓어지고 있습니다.

그 가치 제공 범위가 점점 더 넓어지고 있습니다.